Mecânica quântica aplica-se ao movimento de objetos macroscópicos

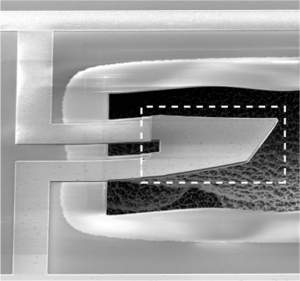

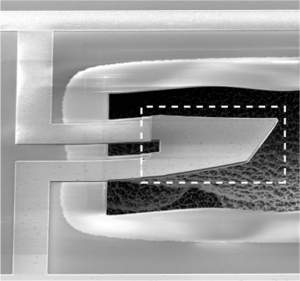

Em um experimento histórico, cientistas demonstraram que uma pequena fita, visível a olho nu, vibra e não vibra ao mesmo tempo, e só escolhe seu estado de energia ao ser observada.[Imagem: O'Connell et al./Nature]

Cientistas da Universidade de Santa Bárbara, nos Estados Unidos, fizeram uma demonstração clara de que a teoria da mecânica quântica aplica-se ao movimento mecânico de um objeto grande o suficiente para ser visto a olho nu.

Novas questões e possibilidades

O experimento abre um mundo de novas questões e possibilidades, a maior delas sendo a mais fundamental de todas: será possível replicar em objetos macroscópicos a propriedade dos objetos quânticos de estarem simultaneamente em dois estados, ou ao mesmo tempo em dois lugares diferentes?

O conhecido experimento mental conhecido como "gato de Schrodinger" demonstra que um gato fechado em uma caixa, cuja vida dependesse unicamente do comportamento de uma partícula quântica, estaria vivo e morto ao mesmo. E a sua sentença definitiva de vida ou morte seria selada no momento em que o estado dessa partícula-carrasco fosse medido.

E os objetos quânticos podem se comportar tanto como partículas quanto como ondas, o que as permite estar em vários lugares ao mesmo tempo. Um elétron, por exemplo, pode estar em qualquer lugar dentre as possibilidades descritas por sua função de onda. Quando um cientista testa sua posição, sua função de onda imediatamente colapsa, fazendo com que o elétron se manifeste tão somente naquele exato local onde a medição está sendo feita.

Os cientistas já conseguiram até inverter essas medições, criando uma espécie de

reencarnação quântica ao cancelar os efeitos de suas medições.

Interface com o mundo quântico

Há poucos meses, um outro grupo de pesquisadores havia demonstrado que uma

esfera levitando por luz torna os fenômenos quânticos detectáveis numa escala maior, embora ainda microscópica.

Mas quem havia chegado mais perto de conectar o mundo quântico ao mundo macroscópico foi o grupo do Dr. Markus Aspelmeyer, da Áustria, que, em Agosto de 2009, estabeleceu uma interação entre um fóton e um ressonador micromecânico, criando o chamado acoplamento forte, capaz de transferir efeitos quânticos para o mundo macroscópico - veja

Mundo quântico comunica-se com o mundo macro pela primeira vez.

Agora, Aaron O'Connell, John Martinis e Andrew Cleland demonstraram que um ressonador mecânico - uma pequena fita metálica que pode vibrar livremente - que foi resfriada até o seu estado fundamental de energia (ground state), funciona em nível macro conforme as probabilidades de mecânica quântica.

Estado fundamental de energia

O nível fundamental de energia equivale ao menor nível de vibração previsto pela mecânica quântica. Uma partícula nunca chega a ter um nível zero de energia, o que lhe daria uma velocidade e uma posição definidas, contrariando o princípio da incerteza de Heisenberg.

O simples fato de colocar um sistema no seu estado fundamental de energia já seria suficiente para colocar esta pesquisa nos anais da história da física.

Os pesquisadores alcançaram o estado fundamental construindo um ressonador mecânico para a frequência das micro-ondas. Ele opera em frequência mais alta, mas seu funcionamento é fundamentalmente o mesmo dos ressonadores mecânicos encontrados na maioria dos telefones celulares.

O ressonador foi ligado fisicamente a um qubit supercondutor, um sistema quântico controlável com grande precisão, utilizado nas pesquisas dos

computadores quânticos. O conjunto foi então resfriado até próximo ao zero absoluto.

Utilizando o qubit como um termômetro quântico, os pesquisadores demonstraram que o ressonador mecânico não continha nenhuma vibração extra. Em outras palavras, ele havia sido resfriado até um nível equivalente ao seu estado fundamental de energia.

Na verdade, a medição garante que o sistema esteja em seu nível fundamental por um determinado tempo. Por mais que o sistema esteja "parado", há sempre forças residuais e uma espécie de "meio quantum" que parece sempre surgir e quebrar sua harmonia.

Objeto macro quanticamente entrelaçado

Com o ressonador mecânico o mais próximo possível de estar perfeitamente parado - onde parado significa parado até ao nível das oscilações dos seus átomos - os cientistas adicionaram a ele um único quantum de energia, um fónon, a menor unidade física de vibração mecânica, provocando-lhe o menor grau de excitação possível.

Os cientistas então observaram o conjunto conforme esse quantum de energia circulava entre o qubit e o ressonador mecânico. Ao trocar essa unidade fundamental de energia, o qubit e o ressonador se tornaram quanticamente entrelaçados, o que significa que qualquer alteração no estado quântico de um deles será imediatamente sentido no outro.

Ou seja, o ressonador respondeu precisamente conforme previsto pela teoria da mecânica quântica - quando os cientistas mediam a energia no qubit, o ressonador mecânica "escolhia" o estado vibracional no qual deveria permanecer.

Medições seguidas mostraram que os resultados seguem exatamente as previsões das probabilidades da mecânica quântica.

Vibrando e não vibrando ao mesmo tempo

Em outro teste, os cientistas colocaram o ressonador mecânico em superposição quântica, um estado no qual ele tem um estado de excitação, ou vibração, que é simultaneamente igual a zero e igual a um, as duas coisas ao mesmo tempo.

Este é o equivalente energético de uma partícula estar em dois lugares ao mesmo tempo.

Ou seja, o ressonador vibrava e não vibrava ao mesmo tempo.

Mas não é de fato possível ver o efeito, porque o simples fato de olhar para o ressonador tira-o da superposição, da mesma forma que a medição de um elétron colapsa sua função de onda e o faz decidir-se por uma posição.

O simples olhar para o ressonador faz com que ele escolha entre vibrar ou não vibrar.

Nanomecânica

O experimento é tão marcante quanto sensível. A temperatura na qual ele funciona é de apenas 25 milikelvin e o efeito dura apenas alguns nanossegundos, já que ele é afetado pelas mais sutis influências do mundo ao seu redor.

A diferença com os experimentos anteriores da mecânica quântica é que a minúscula fita metálica mede 60 micrômetros de comprimento, grande o suficiente para ser vista a olho nu.

"Esta é uma validação importante da teoria quântica, assim como um impulso significativo ao campo da nanomecânica," disse Cleland.

Imaginação quântica

Como um gato não sobrevive a essas temperaturas, ainda não dá para pensar em transformar o gato de Schrondiger em um experimento real.

Na verdade, é muito difícil proteger os mais simples sistemas quânticos dos ruídos externos, fazendo-os funcionar por muito tempo - pelo menos no estado atual da tecnologia.

Mas a comprovação inequívoca do funcionamento da mecânica quântica em objetos macroscópicos abre a possibilidade teórica de que objetos em escala humana possam estar superpostos ou entrelaçados.

Seria possível, por exemplo, ter fónons, fótons e elétrons, em quantidades bem definidas, ou quantizados, mesclados e operando conjuntamente no interior de um aparato como um chip, com possibilidades de exploração nem sequer imaginadas.

Leis desconhecidas

Mas muitos físicos alertam que leis físicas da natureza ainda não descobertas podem simplesmente impedir que objetos realmente grandes atinjam estados quânticos como a superposição e o entrelaçamento.

Só há um jeito de saber quem tem razão: repetir o experimento agora realizado com objetos cada vez maiores e ver até quando os resultados se manterão.

Fonte: Site Inovação Tecnológica